肖恩技术周刊(第 39 期):战斗,爽!

肖恩技术周刊(第 39 期):战斗,爽!

对周内阅读的技术内容精品(个人向)进行总结。觉得不错可点击上方订阅,第一时间获取更新通知。

狩猎解禁!这作新增的“相杀“机制真的是太爽了,与怪物硬碰硬,正反馈拉满。虽然剧情还是一如既往的拉胯,但玩怪物猎人谁看剧情呢。人物捏脸也精细多了,看板娘也终于正常了,不用像世界那样被aibo折磨了。

业界资讯

刚刚,GPT-4.5问世!OpenAI迄今最大、最贵模型,API价格飞涨30倍,不拼推理拼情商

2025年2月28日,OpenAI发布了其最新聊天模型GPT-4.5。该模型是OpenAI迄今为止最大、最强的模型,强调“情商”和自然交互能力的提升。GPT-4.5通过扩展无监督学习,增强了模式识别、创造性见解和减少幻觉的能力,但并非推理模型。其知识库更广泛,能更好地遵循用户意图,尤其在写作、编程和解决问题方面表现出色。测试显示,GPT-4.5在事实性回答、人类协作等方面优于前代模型,但在数学和编程能力上仍逊色于部分推理模型。目前,GPT-4.5支持搜索、文件和图片上传等功能,未来将扩展多模态功能。API价格因计算资源需求大幅上涨,每1M token收费75美元,比GPT-4o高出30倍。OpenAI仍在评估是否长期提供GPT-4.5 API。

全球首个混合推理模型:Claude 3.7 Sonnet来袭,真实编码力压一切对手

Anthropic 发布了其迄今为止最智能的模型 Claude 3.7 Sonnet,这是市面上首款混合推理模型,具有标准和扩展思考模式,用户可通过 API 对思考时间进行细粒度控制。同时推出的 Claude Code 工具,使开发人员能从终端将工程任务委托给 Claude。Claude 3.7 Sonnet 在编码和前端 web 开发方面表现出色,成为 Anthropic 最佳编码模型,可通过多种计划和平台使用,价格与前代相同。该模型在多个基准测试中表现优异,尤其在 SWE-bench Verified 和 TAU-bench 上实现 SOTA 性能。Anthropic 还对模型进行了安全性和可靠性评估,未来希望 Claude 能成为独立自主工作的专家级智能体,解决复杂难题。

90后北大校友破解挂谷猜想,陶哲轩激动转发!网友:预定菲尔兹奖

近日,北大校友王虹与哥大数学副教授Joshua Zahl在三维空间中证明了困扰数学家上百年的挂谷猜想(Kakeya猜想),引发广泛关注。该猜想由日本数学家挂谷宗一于1917年提出,断言包含每个方向上单位长度线段的集合(Kakeya集)在三维空间中具有Minkowski和Hausdorff维度等于3。王虹和Zahl通过127页论文,采用多尺度分析技术,引入非聚集条件、Wolff公理等进行论证,最终证明了猜想。王虹1991年出生于广西桂林平乐县,16岁考入北大地球与空间物理系后转入数学系,2011年获学士学位,后在巴黎综合理工学院、巴黎第十一大学、麻省理工大学深造,目前是纽约大学数学系副教授。此次突破使她成为2026年菲尔兹奖热门人选,有望成为首位中国籍女性菲尔兹奖得主。

技术博客

亚马逊S3是如何以99.999999999%的持久性存储350万亿个对象(英文)

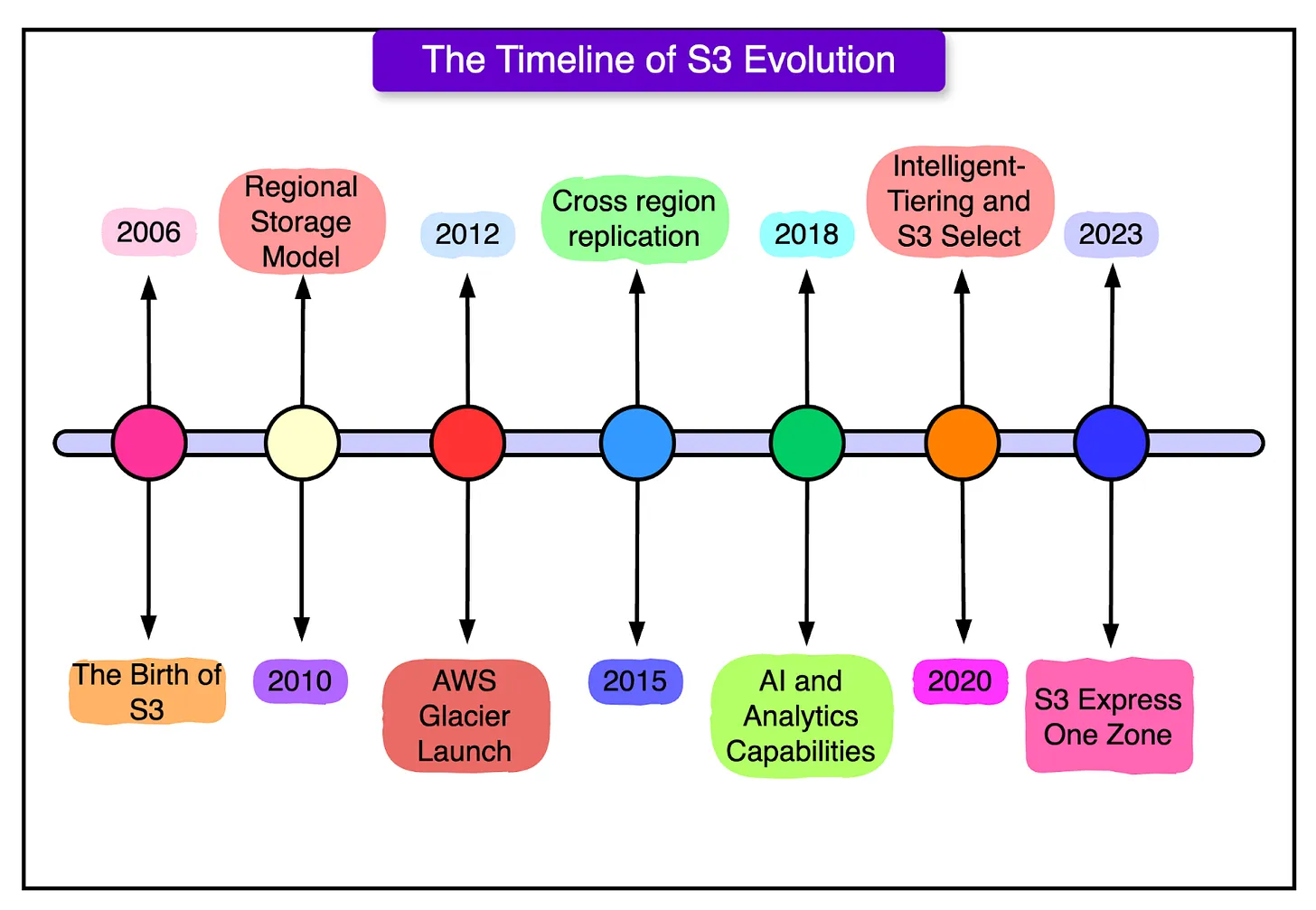

本文详细介绍了亚马逊S3如何存储350万亿个对象,并实现99.999999999%(11个9)的持久性。S3是亚马逊于2006年推出的云存储服务,已成为现代云计算基础设施的核心。它支持从个人开发者到大型企业的各种需求,提供可扩展、安全且易于使用的存储解决方案。S3通过自动扩展存储容量、提供多种存储类别(如S3标准、智能分层、冰川和S3 Express One Zone)以及与AWS其他服务(如Lambda、CloudFront、Athena等)的集成,满足不同数据访问频率和成本优化的需求。

S3的架构基于微服务设计,包含超过350个微服务,分布在多个AWS区域和可用区,负责存储、检索和保护数据。其前端请求处理服务接收API请求,进行身份验证和路由;索引和元数据服务通过分布式索引跟踪对象位置;存储和数据放置服务使用纠删码和多可用区复制保护数据;读写优化服务通过多部分上传和缓存提高性能;持久性和恢复服务通过校验和验证和自动修复确保数据完整性;安全和合规服务则保护数据免受未经授权的访问和网络威胁。

S3的数据写入过程包括客户端发送写入请求、DNS解析和路由、负载均衡器和Web服务器处理请求、对象索引到元数据存储、数据放置和存储,最后向客户端发送响应。S3的索引系统通过分布式索引和键分区引擎实现快速查找和高并发处理,支持超过1亿次/秒的请求处理能力,同时通过动态分区和负载均衡避免热点问题。

S3的演变历程包括从全球模型到区域模型的转变、引入Glacier、增强性能和安全性、集成AI和分析能力、推出智能分层和S3 Select等功能。S3的持久性和高可用性得益于多可用区存储、自动扩展和AI驱动的预测性扩展策略。通过这些技术,S3成为支持媒体流、人工智能工作负载、实时分析和关键任务应用的基石。

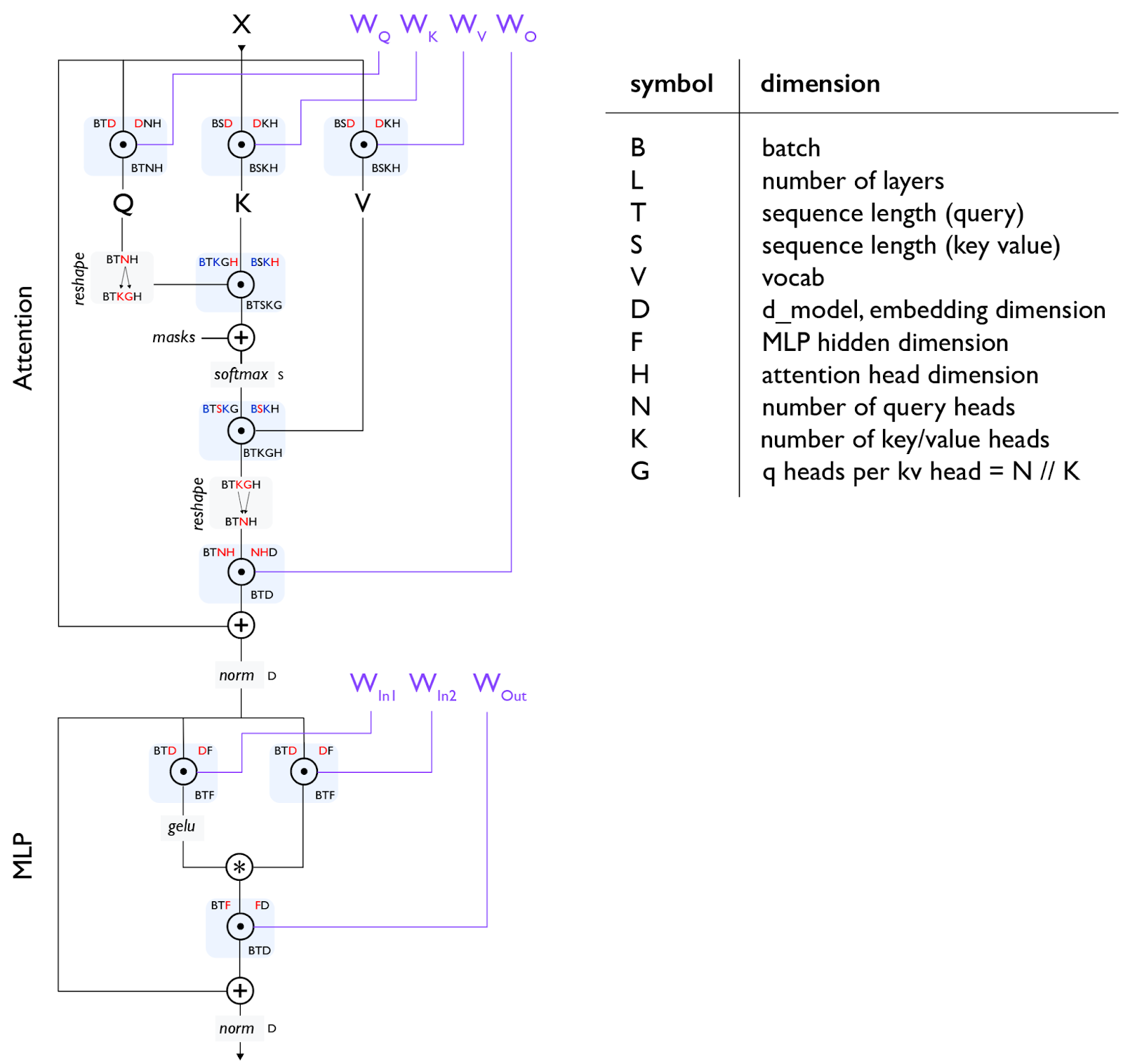

如何扩展你的模型(英文)

一本面向机器学习研究者和工程师的实用指南,旨在帮助读者深入理解Transformer架构、硬件优化以及大规模模型训练和推理的实践技巧。文中强调了硬件与算法协同设计的重要性,并通过丰富的案例和工具支持,帮助读者实现模型性能的最大化。

文章首先介绍了深度学习中“模型扩展”的重要性,指出即使是小型模型也常常接近硬件极限,因此研究者需要关注大规模效率。作者通过屋顶线分析(Roofline Analysis)解释了计算、通信和内存如何限制模型的扩展能力,并详细讨论了TPU和GPU的工作原理以及它们如何通过有限带宽和延迟的互连网络协同工作。此外,文中还探讨了矩阵乘法的性能瓶颈以及如何利用硬件特性优化模型。

在Transformer架构方面,文中深入分析了其参数数量、FLOPs(浮点运算次数)的计算以及KV缓存的大小。通过数学分析,作者展示了如何计算Transformer在训练和推理过程中的计算量和内存使用。文中还讨论了四种主要的模型并行化技术:数据并行、张量并行、流水线并行和专家并行,这些技术可以帮助研究者在给定硬件平台上高效地训练和推理大规模模型。此外,文中还介绍了其他优化技术,如重计算、优化器/模型分片(ZeRO)、主机卸载和梯度累积。

文中通过LLaMA-3模型的训练和推理案例,展示了如何将理论应用于实际问题,并讨论了在TPU上训练和推理LLaMA-3的成本、时间和性能优化策略。此外,文中还介绍了如何使用JAX和XLA(加速线性代数)堆栈进行性能分析,并提供了使用JAX/TensorBoard分析器调试和优化代码的实用指南。

核心 Git 开发人员如何配置 Git(英文)

文章分享了Git核心开发者常用的配置方法,旨在帮助用户优化Git的使用体验。作者将配置分为三类:明显提升效率的配置、值得尝试的配置以及因人而异的配置。

明显提升效率的配置包括优化分支和标签的排序(如branch.sort和tag.sort)、设置默认分支名称(init.defaultBranch)、改进diff显示(如diff.colorMoved和diff.renames)、优化推送和抓取行为(如push.default和fetch.prune)。这些配置可以显著提升Git的可读性和操作效率。

值得尝试的配置 包括自动纠正提示(help.autocorrect)、提交时显示diff(commit.verbose)、记录冲突解决方案(rerere.enabled)、全局忽略文件(core.excludesfile)和优化变基体验(如rebase.autoSquash)。这些配置提供了额外的便利性和上下文信息,帮助用户更好地管理代码。

因人而异的配置 包括改进合并冲突显示(merge.conflictstyle)、设置拉取行为(pull.rebase)和运行文件系统监视器(core.fsmonitor)。这些配置需要根据个人偏好和项目需求选择。

开源项目

chinese-weekly-hub:中文周刊合集

有意思的中文周刊,拓宽视野,打破信息差。

watermark-removal:AI去水印

利用AI去除水印。

docling:文档和AI之间的桥梁

Docling是一个由IBM开发的开源工具,旨在简化文档处理流程。它支持多种文档格式(如PDF、DOCX、XLSX、HTML等)的解析,并提供与生成式人工智能生态系统的无缝集成。

资源推荐

ai-by-hand-excel:通过Excel讲解AI原理

在Excel中学习AI。

Linux101-docs:学习Linux

中国科学技术大学 Linux 用户协会编写的Linux入门指南。

project-based-learning:做项目学习编程

通过实际项目学习编程技能。